“自动化”这个词既让人联想到技术和社会的进步,又让人深感恐惧。

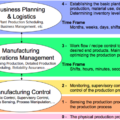

近年来,制造商通过工业4.0计划来追逐自动化。随着引入一个个新的机器人、物联网或人工智能驱动的设备(其中的交叉点被称为AIoT),制造商向自动化又迈进了一步。但是,另一些人会担心,制造车间每引进一台机器、人工智能驱动的摄像头或机器人,就可能有一个工人面临失业。

Covid-19疫情极大地改变了围绕自动化看法。摄像头、机器和人工智能现在更被视为盟友,而不是威胁。这些设备是一种手段,可以更好的解决当下社交距离、远程工作、供应链中断、计划外停工和远程工作等一系列问题。

上述原因使人工智能的应用越来越深入,即使在病毒最终驱散,这种情况也将会持续下去。但是,随着人工智能在工厂车间被广泛和轻易地采用(例如:智能质检,为质量检查供给一双辅助的眼睛),一系列新的问题将出现。

原文:Why ‘Explainability’ Is The Next Step For AI In Manufacturing

作者:CEO of Neurala, Max Versace 节选:数字基座

随着制造商越来越习惯采用人工智能,关于人工智能的工作方式和决策原理问题就会被关注。

从本质上讲,现在我们已不再讨论是否需要人工智能——答案是“是!需要”。而现在新的问题是人工智能“为什么”做出了决策。也就是说,随着人工智能现在在从医疗保健、电子商务、网络安全、工业制造等行业中开始执行关键功能,企业需要更多的可理解的方法来描述人工智能是“如何”,以及“为什么”做出决策的。

例如,制造车间的典型视觉质量检测过程。正常产品图像和缺陷产图像被输入到人工智能系统,然后进行学习,我们可以追溯并确认出AI会判断哪些组件被认为是 “正常 “而不是 “异常”。我们还可以在图像去标记强调一些像素区域、图像特征来强化判断。从这个例子上看,尽管还不能像人类检验员那样说出决策的过程,但人工智能系统可以被询问、被理解和利用其决策结果。

可解释的人工智能(Explainable AI)是近年来人工智能技术库中一个相当新的补充。如今,它包括软件代码实现,通过友好的用户界面,能够向工人提供出人类可读的信息。说明给定的数据(输入)是如何变成一个特定的决策结果(输出)。此外,可解释的人工智能对于问责和审计的目的也非常有用。让人能理解AI系统为什么会做出 “缺陷”的判断,有助于准确定位制造车间的缺陷,并确定如何改进整体流程。

随着越来越多的工人被自动化系统包围着,人工智能不仅需要有效率,而且需要被信任。就像我们人类,如果同事能够阐述清楚达成决策的理由和过程,就会对他们产生信任一样。我们需要学会信任部署在工厂车间的人工智能。建立这种信任是进一步释放人工智能和自动化在制造业真正潜力的基础。

一旦你了解了需求,接下来要考虑的是如何切实增强工业AI系统的可解释性。窥视深度学习网络,追踪决策过程,并将结果以可靠的、人类可读的形式呈现出来,这是有技术难度的。从头开始开发这个功能很可能会导致大量的时间和资本支出,并且可推广复制性差。你最好的选择是找到一个可以专业合作伙伴。在寻找合作伙伴的过程中,企业领导者应该关注人工智能平台和框架,这些平台和框架原生地包含了一种将人工智能预测整合到决策过程中的方法,其中包括如何解释决策过程。

AI可解释性将发展为特定行业(比如在制造业中)必须具备的条件,这将为新工具广泛地采用铺平道路。